TL;DR

DeepSeek ist ein Large Language Model (LLM) mit Fähigkeiten, die sich durchaus mit ChatGPT, ClaudeAI, Gemini etc. messen können. Das Besondere: Es kann in kleineren Varianten sogar lokal auf Consumer-Grafikkarten (z. B. einer RTX 4090) betrieben werden und erfordert somit keine Verbindung ins Internet bzw. zu irgendeinem Drittanbieter. Gerade für Unternehmen in Deutschland und Europa, die strenge Compliance- und Datenschutzvorgaben erfüllen müssen, kann das ein echter Wendepunkt sein. Warum? Weil sich Daten auf diese Weise sogar “airgapped” verarbeiten lassen, also ohne das eigene Firmennetzwerk jemals verlassen zu müssen.

Herkunft und Besonderheiten von DeepSeek

Wer in letzter Zeit etwas von Künstlicher Intelligenz mitbekommen hat, denkt sofort an ChatGPT oder ähnliche Services der großen US-Anbieter. Das ist verständlich, denn diese Player dominieren mit ihren sehr guten Lösungen den Markt. Dass es daneben noch weitere Modelle gibt, bleibt oft unter dem Radar. DeepSeek ist bzw. war eines dieser Modelle, bis es nun in der aktuellen Version in den Fokus der breiten Öffentlichkeit gerückt ist.

-

Vergleichbare Fähigkeiten wie ChatGPT

DeepSeek wurde speziell darauf getrimmt, kontextsensitiv Texte zu generieren oder zu interpretieren, ähnlich wie die anderen bekannten LLMs. Genau wie diese kann es komplexe Fragen beantworten, Code analysieren und generieren oder einfach große Textmengen zusammenfassen. -

Datenschutz und Sicherheit im Fokus

Anders als bei vielen Cloud-Angeboten, bei denen Daten durch den jeweiligen Anbieter verarbeitet werden, liegt bei DeepSeek die komplette Kontrolle über Daten und Abläufe beim Nutzer. Das erfüllt den Anspruch vieler europäischer Unternehmen, souverän über ihre Informationen und deren Verarbeitung zu entscheiden. -

Dynamische Entwicklung

Der Markt an verfügbaren LLM-Modellen verändert sich ständig und die Richtung ist klar: Es geht immer schneller vorwärts. Vermutlich ist dieser Artikel schon wenige Tage nach Veröffentlichung schon wieder überholt. Gedrucktes ist tot - besonders in Zeiten von KI. Und genau deshalb sollten Unternehmen das Beste daraus machen.

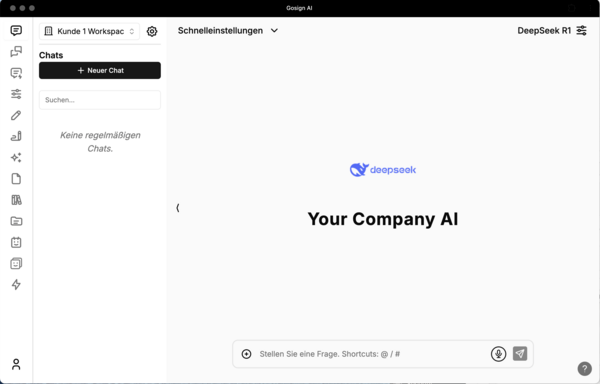

Profitieren Sie von unserer Erfahrung: Wir machen Ihre KI-Projekte greifbar und umsetzbar.

Game changer: Lokaler Betrieb auf Consumer-Grafikkarten

Laut Hersteller konnte das Modell in Rekordzeit mit rekordverdächtig sparsamer Hardware erzeugt werden. Da ich kein ausgewiesener Experte für das Trainieren von LLM-Modellen bin, will ich die Qualität dieser Aussagen nicht bewerten. Unbestreitbar ist aber, dass sich DeepSeek durch ein Alleinstellungsmerkmal hervorhebt:

DeepSeek lässt sich lokal auf ganz normalen Consumer-Grafikkarten wie einer NVIDIA RTX 4090 betreiben. Oder in einem MacMini-M4-Cluster, oder oder oder. Mit einer solchen “Heim-Hardware” kann man nun also komplette LLM-Prozessketten abwickeln, die bislang nur in der Cloud liefen oder eben mit anderen OpenSource LLMs, deren Leistungsstärke jedoch nicht an die von DeepSeek heranreichte.

-

Weg vom Hyperscaler? Warum nicht!

Wer Cloud-Plattformen mag, kann DeepSeek natürlich auch in einer Cloud-VM betreiben. Aber die wahre Stärke liegt gerade im lokalen Betrieb, denn hier gilt das Prinzip “Your Data, Your Rules”. -

Skalierbar und trotzdem beherrschbar

Die benötigte Infrastruktur ist oftmals schon in vielen Unternehmen vorhanden. Eine einzelne High-End-GPU kann das Modell hosten – und wenn man mehr Power braucht, skaliert man auf mehrere GPUs, ohne dafür komplett von externen Diensten abhängig zu sein. -

Kontrolle, Kontrolle, Kontrolle

Keine Daten wandern ins Netz, keine unklare Datenverarbeitung durch Dritte – alles passiert in Ihrer eigenen Hardware-Umgebung. Damit ist DeepSeek, wie oben bereits erwähnt, sogar “airgapped” denkbar: Wer die Sicherheit eines isolierten Netzes schätzt oder aus Compliance-Gründen darauf angewiesen ist, ist hier bestens aufgehoben.

Warum das für viele Unternehmen in Deutschland und Europa relevant ist

Viele Entscheider befinden sich momentan in einer Zwickmühle: Einerseits sollen modernste KI-Lösungen zum Einsatz kommen, andererseits wecken Datenschutzregelungen und Compliance-Vorgaben (Stichwort DSGVO) nicht zu Unrecht Skepsis gegenüber US-Diensten oder 3rd-Party Dienstleistern im Allgemeinen. DeepSeek löst genau dieses Problem.

-

Compliance und Datenschutz

Ein KI-Modell, das lokal läuft, speichert Texte, Eingaben und Lernfortschritte ausschließlich innerhalb der Unternehmensgrenzen. Da wird keine Verbindung zu fremden Servern benötigt, was den Datenschutzbeauftragten vor Freude in die Hände klatschen lässt. -

Sensible Branchen, sensible Daten

Stichwort “Kritische Infrastruktur”: Überall dort, wo sensible Informationen verarbeitet werden, ist das Risiko, Daten “außer Haus” zu geben, oft ein No-Go. Externe LLMs dürften hier nur selten zum Einsatz kommen. Wenn überhaupt. -

Kosteneffizienz und Flexibilität

Schauen wir uns die Alternativen an: Bei Cloud-Angeboten zahlen Unternehmen in vielen Fällen “Pay per Use”, was bei hohem Anfragevolumen schnell teuer werden kann. Ein eigenes Setup mit DeepSeek auf einer ordentlichen Consumer-GPU rechnet sich für viele Workloads oft besser – und man hat die Flexibilität, alles so anzupassen, wie es die Geschäftsprozesse erfordern. -

Unabhängigkeit von Hyperscalern

Der Trend, sich von großen Cloudanbietern zumindest teilweise zu lösen, wächst. DeepSeek trägt dieser Entwicklung Rechnung, ob beabsichtigt, oder nicht. Man ist nicht mehr gezwungen, sämtliche KI-Workloads in einer Public Cloud laufen zu lassen, sondern kann sich eine eigene, skalierbare Umgebung aufbauen.

Fazit

DeepSeek ist mehr als nur ein weiterer Player im LLM-Markt und markiert einen nächsten, wichtigen Meilenstein im weltweiten KI-Marathon. Indem Hochleistungs-KIs auf “normaler” Hardware ermöglicht werden, finden Unternehmen in Deutschland und Europa nun eine echte Alternative zu ChatGPT, ClaudeAI, Gemini & Co vor.

Wer sich bislang gefragt hat, ob zu ChatGPT eine datenschutzkonforme und lokal betreibbare Alternative existiert, sollte sich DeepSeek genauer ansehen. Für Europa könnte das ein entscheidender Schritt sein, um sich im KI-Bereich zu emanzipieren und gleichzeitig auf dem neuesten technologischen Stand zu sein.