Anleitung: NAS System mit AMD Ryzen und TrueNAS Core

Network Attached Storage- bzw. kurz NAS-Systeme erfreuen sich bereits seit Jahren großer Beliebtheit: Egal ob Unternehmen oder Privathaushalt, auf NAS-Systemen speichert man per Netzwerk alles an einem zentralen Ort, was irgendwie schützenswert ist oder im Netzwerk für alle Kollegen bzw. Familienmitglieder verfügbar sein soll.

Wer hier eine gute Out-Of-TheBox-Lösung bevorzugt, kann zu renommierten Marken wie QNAP und Synology greifen. Wer jedoch Spaß am Tüfteln und individualisieren hat, für den ist dieser Artikel gedacht: Ich habe ein NAS zusammengestellt und beleuchte die einzelnen Komponenten und meine Gründe für deren Auswahl.

Ich hatte bereits im Jahr 2014 ein DIY NAS-System zusammengebaut, das mir seither treue Dienste geleistet hat und davor verschiedene QNAP- und andere Systeme im Einsatz. Ich wusste also recht genau, was mir beim Aufbau eines 2021er Folgesystems wirklich wichtig war. Hier gilt natürlich “Your mileage may vary” - andere Einsatzszenarien erfordern andere Leistungsmerkmale.

LEISTUNG! LOOKS! LUXUS? WAS MUSS ICH BEDENKEN?

- 1. Preis: obwohl das System auch etwas professionelleren Ansprüchen in puncto Leistung, Verfügbarkeit und Qualität genügen soll, ist es in erster Linie doch ein Hobby-Projekt und damit ist der Preis ein entscheidender Faktor.

- 2. Leistung: Der Flaschenhals am alten System waren am ehesten CPU-Leistung für virtualisierte Workloads und Netzwerkleistung. Hier wollte ich also auf jeden Fall Leistung nachrüsten.

- 3. Stromverbrauch: ich wollte ein System mit vergleichsweise hoher Prozessorleistung und mindestens acht 3,5“-Einschüben für Festplatten, wodurch der Stromverbrauch beim 24/7-Betrieb eine relevante Größe darstellt.

- 4. Kapazität: Neben der fehlenden Leistung war fehlender Plattenplatz der andere dringende Grund für die Aufrüstung des Systems.

- 5. Coolness: gerade weil es ein Hobby-Projekt ist, muss das System auch irgendwie cool sein: Auch ein Servergehäuse kann chic aussehen.

WAS BRAUCHE ICH UND WAS WILL ICH?

- Ich will 10 Gigabit-Networking, primär für schnelle Datenübertagung von Plattenbackups auf das NAS und schnelles Arbeiten mit z.B. Fotoarchiven über Netzwerk.

- Ich will eine CPU mit mindestens 15.000 Punkten beim Passmark CPU Mark, um Kubernetes- und virtualisierte Workloads performant laufen lassen zu können.

- Ich will ECC-RAM, also Speicher mit integrierter Fehlerkorrektur, da dieser für die NAS-Software “TrueNAS CORE” (mehr dazu später) dringend empfohlen wird. Das bedingt auch ein Mainboard und eine CPU, die beide ECC-RAM unterstützen.

- Es müssen, wie oben beschrieben, mindestens acht 3,5“ Festplatteneinschübe her, weil ich bereits ein Array von 5 Platten habe, das voll ist.

Ich werde einige Teile neu kaufen (u.a. CPU, RAM, Mainboard) weil:

- Ich die Prozessoren der gerade nicht mehr aktuellen Generation vergleichsweise günstig bekomme und diese die größte Leistung für den kleinsten Preis liefern.

- Eine aktuelle CPU, und hier tendierte ich zu AMD Ryzen, unterstützt nur DDR4-RAM, also muss auch neuer DDR4-(ECC)-RAM her.

- Ryzen der 3. Generation unterstützen PCIe V.4 und auch wenn Boards mit PCIe V.3 kompatibel und performance-technisch absolut ausreichend sind, tendiere ich wegen zukünftiger Aufrüstbarkeit etwas mehr Richtung PCIe V.4-Board.

Und ich werde einige Teile gebraucht (u.a. SAS-Controller, Gehäuse, ggf. Netzwerkkarte) kaufen, weil

- Servergehäuse gebraucht erheblich günstiger sind und zumindest bei Markenherstellern oft qualitativ so gut, dass man keinen baldigen Ausfall erwarten muss und selbst dann eine gute Ersatzteilverfügbarkeit besteht.

- SAS-Controller: Wer mehr Festplatten anschließen will, als SATA-Steckplätze auf dem Board vorhanden sind, sollte zu einem SAS-Controller greifen - und eben nicht zu einem SATA-Controller, was auf den ersten Blick vielleicht mehr Sinn zu ergeben scheint. Auf das “warum” gehe ich unten näher ein. Die sind gebraucht sehr viel günstiger zu haben als neu.

- 10 GbE-Netzwerkkarten waren früher einmal teure Server-Hardware und sind mittlerweile günstig auf dem Gebrauchtmarkt zu bekommen, während neue 10GbE-Netzwerkkarten im Consumer-Segment zumindest mir persönlich oft weniger attraktiv erschienen und die aus dem Enterprise-Markt immer noch sehr teuer sind.

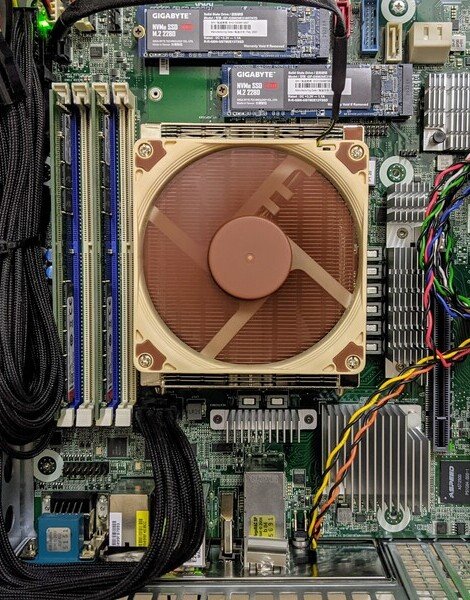

Das Innenleben des neuen NAS Systems: Ryzen Prozessor auf ASRock Rack Board in einem Supermicro 2 HE Gehäuse

WAS ICH GEKAUFT HABE UND WARUM:

CPU: AMD Ryzen 3600 6-Core/12-Threads-Prozessor

- Für knapp unter 160 € bekommt man aktuell meines Erachtens kaum irgendwo mehr Leistung pro € und das für eine TDP von 65W, die man im ECO-Mode auf 45W ohne spürbare Leistungseinbußen drücken kann. Den fast doppelten Preis für einen aktuellen Ryzen 5 5600X habe ich mir im Hinblick auf das im Verhältnis niedrige Leistungsplus gespart.

- AMD unterstützt auch in seinen Ryzen Consumer-Prozessoren ECC-RAM, während Intel das Ganze nur noch für seine Xeon-Prozessoren anbietet, was ihnen Anfang des Jahres einen entsprechend erwartbaren Kommentar von Linus Torvalds einbrachte:

“ ECC absolutely matters. Intel has been detrimental to the whole industry and to users because of their bad and misguided policies wrt ECC. Seriously. And if you don’t believe me, then just look at multiple generations of rowhammer, where each time Intel and memory manufacturers bleated about how it’s going to be fixed next time. And yes, that was – again – entirely about the misguided and arse-backwards policy of ‘consumers don’t need ECC’, which made the market for ECC memory go away. “

Warum ich mich gegen eine Alternative entschieden habe:

- Alternative A) Gebrauchte Serverboards: Ein gebrauchtes Serverboard mit zwei oder gar vier älteren XEON-Prozessoren und vergleichbarer Leistung ist auf eBay zu fairen Preisen zu finden. Die schlagen dann allerdings je nach Modell und Board-Bestückung schnell mit u.U. erheblich mehr als 300, 400 oder gar 500 Watt Stromverbrauch zu Buche, was spätestens bei der nächsten Stromrechnung jeglichen Preisvorteil zunichtemachen dürfte. Dazu käme ein erheblich höherer Kühlungsbedarf, was der Server mit entsprechendem Lüfterlärm quittiert.

- Alternative B) Neue Serversysteme auf Basis von Intel XEON, AMD Threadripper oder AMD EPYC: Hier war schlicht die Kombination aus Preis und Stromverbrauch der ausschlaggebende Faktor: Die Vorteile “erheblich mehr RAM” (Zumindest bei XEON und EPYC) und “Erheblich mehr PCI-Lanes” hätte ich in meinem Szenario auch kaum honorieren können.

Mainboard: ASRock X570D4U-2L2T

Dieses Board ist eines der ganz wenigen, “that checks all the boxes”, vielleicht sogar das Einzige, wenn man folgende Features haben möchte:

- AM4-Sockel für AMD Ryzen Prozessor

- ECC-RAM-Support

- IPMI (Intelligent Platform Management Interface): Das ist eine per Netzwerk erreichbare Remote-Management-Oberfläche, die einem Administrator über Netzwerk virtuell mit “Bildschirm und Tastatur” des Servers verbindet. Im Endeffekt ein Computer im Computer. Beispiel: Die älteren Versionen des auf diesem Board verbauten BIOS unterstützen nur Ryzen-Prozessoren der 3. Generation. Ein Ryzen der 5. Generation funktioniert erst nach einem BIOS Update. Was also tun, wenn man keinen Ryzen der 3. Generation herumliegen hat? Kein Problem! Einfach anschalten, per IPMI das BIOS-Updaten, Neustarten und schon wird auch der neue Prozessor erkannt. Danach kann man auch über das IPMI ins BIOS selbst und weitere Einstellungen vornehmen, dem Bootvorgang live zuschauen - und das alles in einem HTML5-Browserfenster. Ein must-have für alle Server, an denen man nicht andauernd Bildschirm und Tastatur angeschlossen haben möchte.

- 10 GbE OnBoard: Es gibt noch ein Schwestermodell ohne die beiden 10 GbE RJ-45 Ports on board, aber zum Zeitpunkt des Kaufs war der Preisunterschied zwischen beiden Modellen so gering, dass eine gebraucht zugekaufte 10GbE RJ-45-Karte praktisch keinen Unterschied gemacht hätte und so habe ich außerdem einen weitere PCIe-Slot frie.

- 2 NVMe-Steckplätze on Board: Damit ich die 10GbE-Netzwerkleistung auch garantiert voll ausnutzen kann, sollten zumindest Teile der Hardware auch netto 1GB/sec oder mehr liefern können. Diese Steckplätze werde ich also auf jeden Fall bestücken.

- PCIe V.4: Wegen etwaiger Aufwärtskompatibilität / Performance

- X570 Chipsatz: Wegen etwaiger Aufwärtskompatibilität / Performance

Kurzum - der perfekte Alleskönner im kompakten Format. Man könnte auch sagen: “Enterprise Features in Consumer Hardware”: Eine Marktnische, die offenbar nur ASRock Rack momentan adressiert und die dem stetig steigenden Preis des Boards nach zu Urteilen immer größer wird.

- NVMe: 2 x 1 TB von Gigabyte (GP-GSM2NE3100TNTD): Wohlwissend, dass es sich hier lediglich um PCIe V.3-Komponenten handelt, hat hier das Preis-Leistungs-Verhältnis gesiegt: 100 € für 1 TB mit erheblich mehr Datendurchsatz pro Sekunde, als selbst beide 10 GbE-NICs parallel pro Sekunde über die Leitung schaufeln könnten reichen hier aus.

- Gehäuse: SuperMicro SuperChassis CSE-826BE16-R920LPB gebraucht (eBay): Ein sehr ordentliches 2HE-Servergehäuse aus dem Hause Supermicro, bereits ausgestattet mit:

- 12 x 3,5“ SAS/SATA-Festplatteneinschüben an der Front

- SAS2/SATA3-Backplane

- 2 x 2,5“ SATA-Einschüben auf der Rückseite

- 2 x 920Watt High Efficiency Redundant Power Supply, 80 Plus Platinum SuperQuiet

- SAS-Controller: SuperMicro AOC-S2308L-L8i (IT-Mode): Und hier wurde es spannend: Ich hatte bis dato noch nie etwas mit SAS (Serial Attached SCSI) zu tun. Mein altes NAS bestand aus 5 SATA-Festplatten, die mit 5 SATA-Kabeln an den 5 SATA-Ports der Mainboards befestigt waren.

Mir war klar, dass das bei 12 Festplatten, die an einer SAS-Backplane hängen, anders laufen muss. Die Backplane ist die Platine, mit der die 12 Festplatten beim Einstecken verbunden werden. Ich habe auch gesehen, dass keine 12, sondern lediglich zwei Anschlüsse von der Backplane in Richtung Mainboard gehen. Einige Artikel und diverse YouTube-Videos später war ich dann im Bilde und hatte folgende Dinge gelernt:

- Man kann SATA-Festplatten an SAS-Festplatten-Anschlüsse stecken. Das wusste ich allerdings schon vorher, denn ich hatte vorab sichergestellt, dass meine vorhandenen Festplatten auch wirklich in diesem Servergehäuse funktionieren würden.

- Diese Kompatibilität ist aber unidirektional: SAS-Festplatten können z.B. nicht an SATA-Controllern betrieben werden.

- SAS ist ein Bus-System: Ein SAS-Kabel beschränkt also die maximale Bandbreite, nicht aber die Anzahl der Festplatten, die man anhängen kann - zumindest nicht bei der Menge Festplatten, um die es bei uns geht.

- Der richtige Weg ist also: SAS-Kabel vom SAS-Controller auf dem Mainboard in den SAS-Input der Backplane stecken. Der zweite Anschluss an der Backplane ist dann lediglich dazu da, im Bedarfsfall weitere Backplanes in Reihe zu schalten.

- Es gibt auch Verbindungskabel von einem SAS-Anschluss auf vier SATA-Anschlüsse. Da ich an der SAS-Controllerkarte ohnehin zwei SAS-Anschlüsse hatte und noch zwei SATA-SSDs in den hinteren Einschüben untergebracht hatte, kam diese Möglichkeit gerade recht - auch wenn ich diese alternativ auch mit zwei der SATA-Ports auf dem Board hätte verbinden können.

- SAS-Controller gibt es üblicherweise entweder als:

- reinen Adapter, der die Festplatten mit dem Mainboard mehr oder minder direkt verbindet (im sog. “IT-Mode”, notwendig für TrueNAS CORE), oder als

- RAID Controller, der die Verwaltung der physischen Festplatten selbst übernimmt und dem System ein logisches Laufwerk anbietet.

- Oft lassen sich SAS-Controller per Firmware zwischen IT-Mode und RAID-Mode umschalten. Das Thema ist sehr viel komplexer, als hier dargestellt. Einen guten Einstieg gibt es hier: https://www.servethehome.com/buyers-guides/top-hardware-components-freenas-nas-servers/top-picks-freenas-hbas/

- Controller dieser Art lassen sich mit etwas Glück bei eBay schon ab 30-40 € erstehen.

- ECC-RAM: 2 x Kingston Server Premier DDR4-3200 (KSM32ES8/16ME): Dieser ECC-Speicher ist in der Liste der offiziell von ASRock Rack für dieses Board unterstützen RAM-Module und 32 GB scheinen mir für den aktuellen Anwendungsfall ausreichend - zwei Slots für eine weitere Aufrüstung auf 64 GB sind so noch frei.

- CPU-Cooler: Noctua NH-L9a-AM4: Das Besondere an diesem Lüfter: es ist ein Low-Profile-Lüfter, der genug Abstand zwischen dem flachen 2 HE-Gehäuse und der oberseite des Servergehäuses lässt, so dass die Gehäuselüfter auch auf niedrigster Stufe noch genug Warmluft abtransportieren können. So bleibt das Gesamtsystem “angenehm ruhig”. Ich schreibe das in Anführungszeichen, da das Gerät im Keller an der Wand hängt und auch bei etwas Brummen niemanden stört. Wenn man die vier Hochleistungslüfter des Servergehäuses jedoch auf volle Leistung hochfährt, durchdringt ein infernalischer Jet-Lärm auch bei geschlossener Feuerschutztüre das Treppenhaus. Auf diese Art der für Server normalen Prozessorkühlung (durch dann passive Kühlkörper auf der CPU) wollte ich entsprechend lieber verzichten.

Und so sieht das fertige System aus: Es wurde mit Hilfe eines 2 HE 19 Zoll Wandmontage-Racks von StarTech platzsparend und servicefreundlich um 90 Grad geschwenkt, senkrecht an die Wand geschraubt:

TRUENAS CORE VON IXSYSTEMS

Ich hatte am alten System bereits über Jahre hinweg FreeNAS als absolut kugelsichere ZFS-basierte NAS-Lösung kennen- und schätzen gelernt, das mittlerweile als TrueNAS CORE immernoch kostenlos als Open-Source-Lösung zur Verfügung steht.

Das Unternehmen https://www.ixsystems.com/ macht dabei einen großartigen Job, treibt die Entwicklung kontinuierlich voran und wird mit TrueNAS SCALE bald auch einen weiterer Zweig des Projekts zur Verfügung stellen, der nicht mehr auf FreeBSD- sondern auf Debian-Basis ein Linux-basiertes TrueNAS-System bieten wird, was Docker und Kubernetes-Workloads auch ohne Vollvirtualisierung ermöglicht. Hier darf man also gespannt bleiben.

Die Vorteile und Features von TrueNAS CORE darzustellen würde den Rahmen dieses ohnehin schon langen Artikels sprengen, weswegen ich entsprechende Websites und YouTube-Videos zum Thema empfehlen kann.

VIELEN DANK!

Disclaimer: Dieser Artikel stellt nur einen kleinen Ausschnitt dessen dar, was ich bei der Recherche zum Thema “Ein NAS selber bauen im Jahr 2021” alles gelernt habe und herausfinden durfte. Hervorheben und (für alle, die ein ähnliches Projekt planen) empfehlen, möchte ich an dieser Stelle einige YouTube-Channels, die mir dabei neben unzähligen Websites, Blogs und Artikeln geholfen haben:

https://www.youtube.com/user/ServeTheHomeVideo https://www.youtube.com/user/LinusTechTips https://www.youtube.com/user/TheTecknowledge https://www.youtube.com/c/Level1Techs https://www.youtube.com/channel/UCNO-7aDO0SEAvhj4lclJj-Q